학부뉴스

[조선일보] 조규진 교수 "손 못 쓰는 환자 생각대로 로봇손이 움직인다"

[IF] 손 못 쓰는 환자 생각대로 로봇손이 움직인다<?xml:namespace prefix = "o" ns = "urn:schemas-microsoft-com:office:office" />

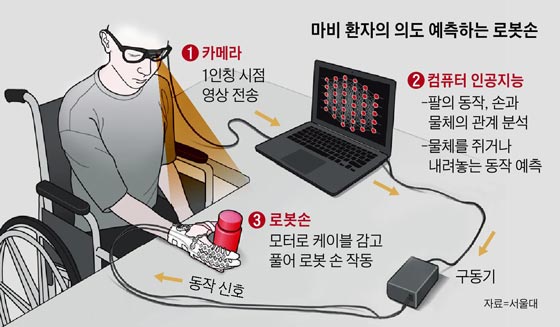

마비환자 시점으로 촬영한 영상, 인공지능이 분석해 행동 예측… 로봇손이 의도대로 작동 성공

국내 연구진이 인공지능으로 마비 환자의 의중을 미리 파악하고 로봇손을 그에 맞춰 작동시키는 데 성공했다. 이번 기술이 발전하면 손을 못 쓰는 환자도 다른 사람의 도움 없이 커피를 마시고 음식을 먹을 수 있다는 기대가 나온다.

서울대 조규진 교수와 KAIST 조성호 교수 등 인간중심 소프트 로봇기술 연구센터 연구진은 30일 "마비 환자의 시점으로 촬영한 영상을 인공지능으로 분석해 어떤 행동을 원하는지 예측하는 데 성공했다"고 밝혔다. 연구 결과는 국제학술지 '사이언스 로보틱스'에 실렸다.

연구진은 앞서 손을 움직이지 못하는 환자를 위해 장갑 형태의 로봇손을 개발했다. 부드러운 재질의 로봇손은 모터의 힘으로 케이블을 당기거나 감아 손가락을 오므리고 폈다. 연구진은 환자나 보호자가 버튼을 눌러 로봇손을 작동할 수 있게 했다.

이번에는 이전과 같은 버튼을 없앴다. 대신 안경에 달린 카메라로 환자가 바라보는 곳을 촬영한 다음, 인공지능으로 분석했다. 인공지능은 반복 학습을 통해 환자가 커피잔을 바라보면서 로봇손을 커피잔 쪽으로 옮기면 커피를 마시려 한다고 판단할 수 있었다. 인공지능은 이후 로봇손의 구동장치를 작동시켜 의도에 맞는 동작을 시켰다. 실제로 어깨나 팔은 움직일 수 있지만 손은 못 쓰는 마비 환자가 이 기술을 이용해 혼자서 커피를 마실 수 있었다.

마비 환자의 생각대로 로봇팔이나 다리를 작동시킨 연구는 이전에도 있었지만 뇌파를 분석하는 방식의 복잡한 과정이 필요했다. 조규진 교수는 "이번 연구는 인공지능으로 영상만 분석해 간단하게 의도를 알아낸 결과"라며 "눈동자 움직임과 근육에 흐르는 전류까지 추가로 분석해 인공지능의 예측력을 더 높일 계획"이라고 말했다. 연구진은 장치의 무게를 줄이고 카메라가 가려지면 인공지능 예측력이 급감하는 문제도 해결해야 할 과제라고 밝혔다.

기사 바로가기

동영상 확인하기 " target="_blank" rel="noopener">